更多CG新聞

MORE CG News

Canva acquired MangoAI and Cavalry

【Canva收購2D 動畫工具 Cavalry 及人工智能公司 MangoAI】

Canva收購了 2D 動畫工具 Cavalry 和人工智能公司 MangoAI, 進一步強化 AI 能力與 專業創意套件

– MangoAI:專注於 data intelligence 與 reinforcement learning, 提升內容行銷產品

– Cavalry:來自英國的 2D animation & motion design tool, 深受專業設計師喜愛 .

透過整合 Affinity 和 Cavalry, Canva 旨在創建一個“Creative OS”能夠持續處理靜態圖像、向量圖、佈局和動態圖像.

另外公布了-前 Netflix VP of Data Science Nirmal Govind 加入 Canva, 成為首位 Chief Algorithms Officer

3rd AI-assisted Animation Production Support Scheme – Workshop

【第三屆「明日動畫」AI輔助動畫製作支援計劃 – 第二場實體培訓講座】

由CCIDAHK贊助、香港數碼娛樂協會舉辦的第三屆「明日動畫」— 人工智能輔助動畫製作支援計劃 主要為入選公司提供資助, 以人工智能(AI)創作動畫.

每家入選的企業最高可獲港幣850,000元的資助, 以AI輔助製作動畫;及參展2026年的法國安錫國際動畫影展暨市場展(Annecy International Animation Film Festival and Market), 藉此開拓更多商機 !!

大會將於2026年3月14日舉行「第二場實體培訓講座」屆時業內專家將分享在AI輔助下如何合法、安全地創作及使用內容 !

是次講座將從實務角度出發,介紹香港、歐洲及內地的版權制度與相關法律發展,剖析AI生成內容的法律風險與合規重點,協助公眾在創新與守法之間取得平衡,適合創作者、企業及關注AI應用人士參與。

主題一:如何在AI時代安全合法地創作和使用內容

日期:2026年3月14日(星期六)

時間:10:00 – 13:00

形式:實體講座(只供已登記人士參加)

地點:香港上環德輔道中199號無限極廣場6樓Happy Moment 603-4號室

費用:全免

語言:廣東話

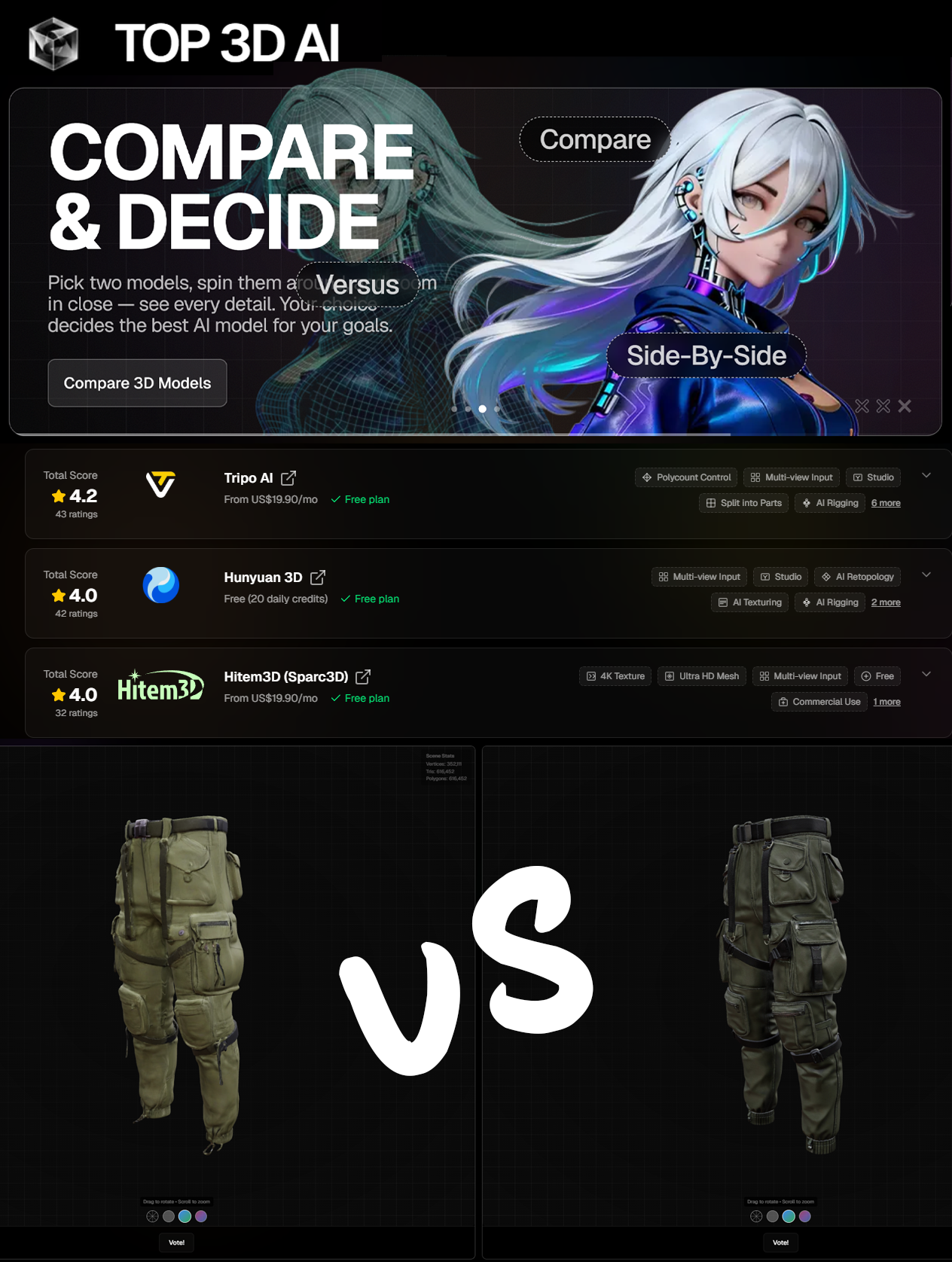

Top 3D AI – Find the Best 3D AI Tool for You

Seedance 2.0 by Bytedance

【Seedance 2.0 又AI影片生成天花板 ? 】

北京字節跳動的最新 AI、影片生成 Seedance 2.0 日前發布即成話題, 亦引發中國科技股上漲 ~

Seedance 2.0 是字節跳動最新推出的 AI 視頻生成模型, 官方來源現僅限於 ByteDance 官網與 Seed 平台, 尚未建立獨立的 2.0 專頁.

此模型的核心突破在於多模態整合與敘事一致性, 能以文字、圖片、音訊作為輸入, 生成多鏡頭連貫影片, 並支援高達 2K 的輸出解析度

與前代相比 Seedance 2.0 在生成速度、角色一致性、唇形同步與情感表情驅動方面均有顯著提升, 支援多語言輸出, 使影片更真實自然.

Seedance 2.0 目前仍在 Beta 階段, 僅開放給部分在”即梦AI” 網站體驗

AntiRender – No sunshine. No happy families. No impossibly green trees. Just cold, honest, depressing reality.

【AntiRender -『反』建築 Render】

AntiRender 一個玩野的『反』建築 Render的 AI 一鍵處理 , 系統會把原圖轉成”現實的殘酷現實”影像:沒有例牌的陽光、沒有快樂家庭、沒有不真實的綠樹, 只剩下冷酷、誠實、令人沮喪的殘酷現實~~

只要簡單上傳一張建築/環境圖片(Render圖/相片), 系統便會回傳「現實版」影像, 網站提供一次免費的gen圖, 其實都可以玩幾多次, 只是若服務失效,可透過捐款維持….

Google – Project Genie | Experimenting with infinite interactive worlds

【Google DeepMind的Project Genie】

Google DeepMind 發布有關使用 Project Genie 建立並探索AI世界模型.

去年中已經介紹過Google DeepMind 推出一個類3D遊戲的AI世界模型 – Genie 3, 而日前他們發表由Genie 3 驅動的 【Project Genie】 , 一個實驗性研究原型, 讓用戶能夠創造並探索無限多樣的世界. 只需使用文字或圖片提示, 即可生成即時建構的互動環境, 並在遊玩過程中持續擴展 ~!!

Project Genie 由 Genie 3 驅動 , 這是一個AI世界模型, 能夠在無限課程的豐富模擬中訓練 AI agents, 並為人工智慧研究開闢了新的領域.

不過…目前僅提供給美國 (18+) 的 Google AI Ultra 訂閱者使用, 並將在未來逐步擴展至更多地區…

LingBot-World: Advancing Open-source World Models

【LingBot-World – 又一款AI世界模型】

Ant Group 旗下的 AI 公司 Robbyant (蚂蚁灵波科技) 公布開源世界模型 LingBot-World , 一個開源的世界模型, 專注於高擬真度、多樣化環境、長期記憶一致性, 以及即時互動 .

它支援影像到影片生成 (Image-to-Video),並提供公開程式碼與模型下載, 目標是推動內容創作、遊戲以及機器人學習等應用.

LingBot-World 基礎架構:建立於 Wan2.2 – 並支援 multi-GPU inference 即時互動, 延遲低於 1 秒, 可透過 HuggingFace 與 ModelScope 取得

玩不到 Project Genie 的, 可以試試這個..頂住先…

Luma AI – Introducing Ray3.14

【Luma AI推出Ray3.14支援以原生1080p生成影片】

Luma Labs 為其影片生成 AI 平台「Dream Machine」推出了一款新模型「Ray3.14」!! 支援1080p, 提升影像品質和生成效率.

此新版本支援以原生 1080p 解析度生成影片, 與上一代型號(Ray3)相比, 生成速度和性價比均顯著提高、速度提升 4 倍、成本降低 3 倍,並在畫質、穩定性與動態一致性上大幅改進.

主要特色如下:

– Native 1080p:在核心 Dream Machine 工作流程中提供高解析度影片生成.

– 速度提升:在 720p 下比 Ray3 快 4 倍.

– 成本降低:在 720p 下比 Ray3 便宜 3 倍.

– Prompt adherence 更佳,生成結果更貼近文字描述,減少 artifacts.

– Modify workflow 改進:在角色、物件、風格上跨幀保持一致性.

– Modify Video 最長可達 18 秒.

Ray3.14 已在 Dream Machine 平台上提供使用!!