更多CG新聞

MORE CG News

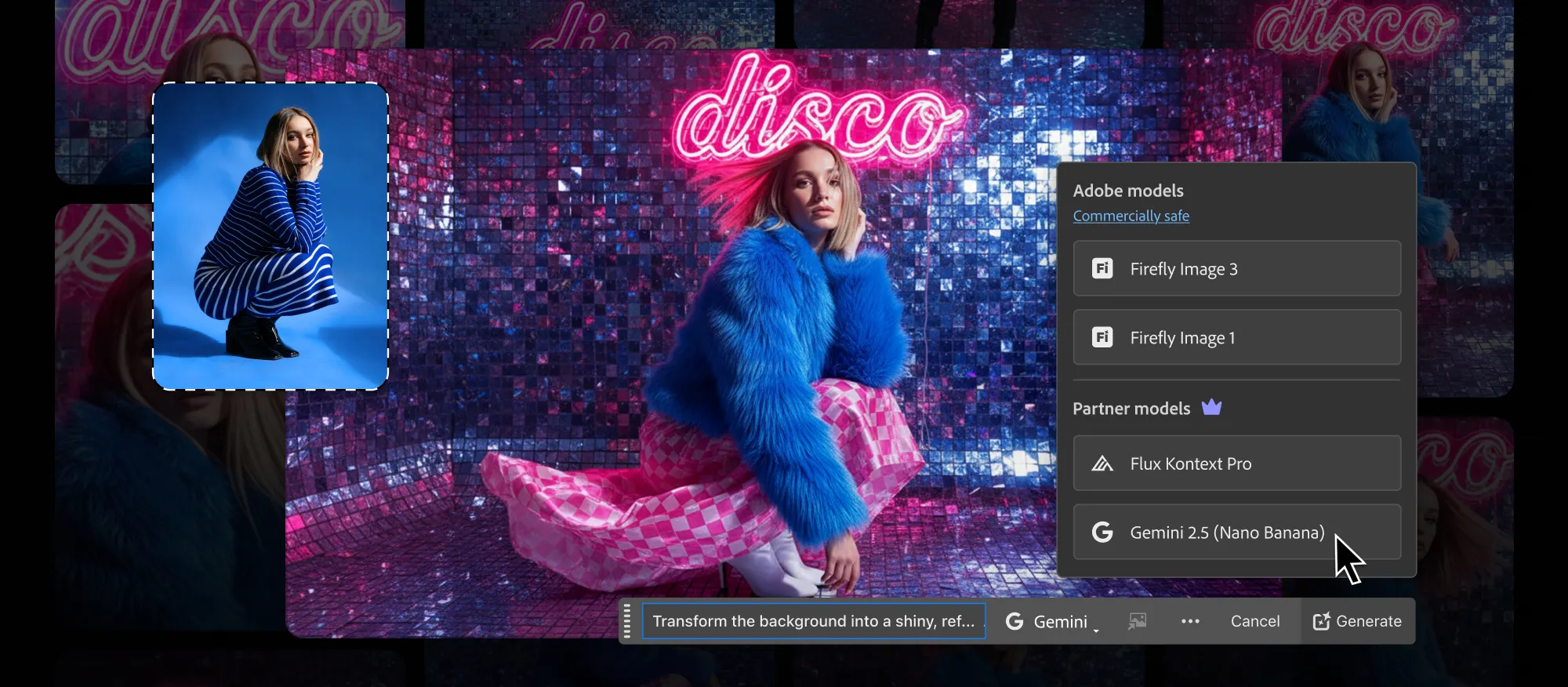

Gemini 2.5 Flash Image (Nano Banana) in PS beta and Gemini 2.5 Computer Use model

【Gemini 2.5 不斷擴展中】

Adobe Photoshop Beta 擴展 Generative Fill 功能, 導入更多 AI 模型與創作可能性

當中有大家都熟悉的Google Gemini 2.5 Flash Image (Nano Banana) 以及 Black Forest Labs’ FLUX.1 Kontext [pro], 支援更複雜的物件移除、背景延伸、內容生成 等功能

現在只要下載Photoshop Beta 軟件即可試用

而 Google 日前推出 Gemini 2.5 Computer Use model 專為操作使用者介面(UI)設計的 AI 模型, 支援網頁與行動裝置控制任務 ,Gemini 2.5 Computer Use model 是基於 Gemini 2.5 Pro 建構的專用模型, 具備強大的視覺理解與推理能力, 能驅動 AI agent 操作使用者介面(UI), 例如點擊、輸入、拖曳等互動行為

模型及Gemini API 已在 Google AI Studio 及香港繞道使用的 Vertex AI 上開放預覽

OpenAI – This is Sora 2

【OpenAI發布Sora 2】

OpenAI日前推出 Sora 2 – 他們最先進的 video generation model

他們稱…Sora 2 能做到許多以往 video generation models 難以實現的事情.

它在物理準確性與真實感方面超越以往系統, 並在 controllability 上有重大突破, 同時還具備 synchronized audio

OpenAI率先在 U.S. 和 Canada 推出, 並計劃迅速擴展至其他國家(明白了). Sora 2 可透過 Sora iOS app 使用. 該 app 現已開放下載(但採取邀請制)

Alibaba’s Wan-Animate

【阿里巴巴的 Wan-Animate】

上月Alibaba 及Tongyi Lab發布 Wan-Animate的研究 – “Wan-Animate: Unified Character Animation and Replacement with Holistic Replication”, 相關模型亦已經開放 – “Wan2.2-Animate-14B” 免費下載使用 ,亦可在wan.video, ModelScope Studio 及 HuggingFace Space上試用

Wan-Animate 能根據表演者的影片為任意角色製作動畫, 精準重現表演者的臉部表情與動作 , 生成極為逼真的角色影片, 而且能將影片中的角色替換為動畫角色, 不僅保留原角色的表情與動作, 還能複製原始光影與色調, 實現與環境無縫融合的逼真效果.

NVIDIA Open Sources Audio2Face Animation Model

【NVIDIA公布將Audio2Face動畫模型開源】

Nvidia 的 Audio2Face是他們開發的 AI 驅動技術,能根據語音輸入自動生成逼真的 3D 臉部動畫, 技術核心在於分析語音中的 phonemes 和 intonation 以實現精準的 lip-sync 和 emotional expressions, 此技術可用於 Offline Render(如預先錄製的內容)或 即時串流(如互動式虛擬角色), 其公布的開源內容與工具包 包括 :

– Audio2Face SDK 及 plugins : Audio2Face SDK / Autodesk Maya plugin / Unreal Engine 5 plugin 及 Audio2Face Training Framework

– Audio2Face models 及 訓練資料 : Audio2Face Training Sample Data / Audio2Face Models 及 Audio2Emotion Models

他們亦分享相關實際應用案例 :

– Reallusion:整合至 iClone、Character Creator 等工具, 支援臉部編輯與 AccuLip 技術

– Survios(Alien: Rogue Incursion):加速 lip-sync 與臉部捕捉流程

– The Farm 51(Chernobylite 2):大幅提升角色表演的真實感與沉浸感

Meta Connect 2025: Fueling the Future of VR

【Meta Connect 2025 – 有關VR的未來發展】

Meta在剛舉行的2025年Connect大會上的發布最新虛擬實境(VR)技術發展與未來展望

從當前 VR 頭戴式裝置到未來 AR 眼鏡, AI 是關鍵解鎖, 隨著使用者成長,新應用案例出現, VR 開發者機會增加, 目前 Meta Horizon Store 上超過 300 款 app 營收超過 100 萬美元, 10 款超過 5000 萬美元, 公告焦點在 Horizon OS 更新, 包括 AI 工具預覽、貨幣化功能、Building Blocks 等工具升級、Android 開發改善, 以及新 Immersive Web SDK

– Meta 推出 Meta Connect Platform (MCP),讓開發者將 Horizon OS 上下文整合到現有 LLM 與 coding assistants 中,加速工作流程、優化與開發

– 六種 Meta Horizon 貨幣化與互動方式

– 三種工具更新,提升建構與測試效率 , 包括: Building Blocks / Passthrough Camera API (PCA) / Meta XR Simulator

– Android 2D 與 Spatial SDK 七項改善

– Immersive Web SDK:簡化沉浸式網路開發

而Meta Connect 2025的另外重點當然放在Meta賣眼鏡…

Autodesk’s AI mission for the future of Media & Entertainment

【Autodesk發表AI願景 : 加入AI Assistant及FaceAnimator】

Autodesk在AU2025活動期間發表他們的AI願景:重寫創作規則

AI 的角色與挑戰 :

– Media & Entertainment 行業面臨高成本、短時限與高期望的壓力

– 根據《2025 State of Design & Make Report》:55% 業界領袖認為 AI 將帶來不穩定性 | 70% 則相信 AI 能提升創造力與工作效率。

Autodesk為創作者建構的 AI 工具包括 :

全新的 Autodesk AI Assistant

– 使用自然語言指令自動化繁瑣任務. 例如調整場景光線

– 讓創作者能夠在後製過程中更快地迭代並直觀地指導場景

即將推出的FaceAnimator

– 從音訊檔案生成面部與唇形動畫

– 可學習任何 production rig 並模仿項目風格

MotionMaker已放在Maya之內的工具

– 結合 keyframing、motion capture 與 machine learning

– 快速生成可用動作,提升動畫製作效率

– Griffin Animation Studios 使用後,製作時間縮短至原本的三分之一

Autodesk Flow Studio

– 提供免費版本讓更多創作者使用 AI 處理複雜 VFX 任務:motion capture / camera tracking / character animation

– Boxel Studio 已用於《Superman & Lois》角色動畫製作

整合製作流程:Autodesk Flow

– Autodesk Flow 是 Media & Entertainment 的產業雲平台

– 功能包括: 團隊即時協作 / 智慧決策 / 從概念到交付的全流程同步

新功能:

– Shared Playlists:整合 Flow Capture 與 Flow Production Tracking 全球團隊可即時評論與對齊

– 與 Avid Media Composer 整合:簡化從製作到後期的編輯流程

Kling AI NextGen Creative Contest

【Kling AI – NextGen創意大賽10月6日截止】

國內AI影像生成平台 Kling AI 可靈 , 日前發布創作比賽【Kling AI NextGen創意大賽】, 邀請全球創作者透過 AI 故事創作, 展現創意與願景!!

– 截止日期: 2025/10/06

– 影片時長: 1 ~ 15 分鐘

– 題材: 不受限

– 規格: 比例不受限,最少720P

– 必須為AI生成影片,非可靈平台最多佔30%

– Grand Prix: 15000美元 + 50萬點Kling AI點數

– Jury x 2: 10000美元 + 20萬Kling AI點數

– Official Selection x 7: 1000美元 + 5萬Kling AI點數

– 大獎及評審獎作品將在東京國際電影節、坎城MIPCOM展、釜山電影展播放

– 大獎及評審獎得主將受邀出席東京國際電影節

此外 ,Kling AI 日前公布最新AI 框架 : Kling-Avatar

– 能夠根據多模態指令(例如文字、語音、視覺提示)生成長時間、高擬真度的虛擬人影片 , 它的目標是讓虛擬角色在敘事和Digital human應用中更具表現力、連貫性與可控性

相關研究文章 : Kling-Avatar: Grounding Multimodal Instructions for Cascaded Long-Duration Avatar Animation Synthesis

Bytedance Seedream 4.0 with ComfyUI support

【字節跳動推出Seedream 4.0 圖像生成AI模型】

國內”字節跳動” (Bytedance) 推出 Seedream 4.0 – AI圖像生成工具 , 可產生4K解析度圖像並具備圖像編輯功能

不僅支援簡單的“從文字生成圖像”,還支援利用模型知識和推理進行圖像生成。它還具備高品質的影像編輯功能 , 功能包括 :

– Text-to-image generation(文字轉圖像生成)

– Image editing(圖像編輯)

– Reference-based generation(參考式生成)

– Multi-image creation(多圖像創建)

為了獲得最佳的圖像生成效果 Seedream 4.0 User Guide 文件提供了撰寫 prompt 的最佳實踐建議

而 Seedream 4.0現已支援Fal和ComfyUI等多個AI生成平台